El scraping de datos con Beautiful Soup es una técnica popular utilizada por los desarrolladores y analistas de datos para extraer información de páginas web de manera eficiente y automatizada. Mediante el uso de Python y la biblioteca Beautiful Soup, se puede acceder a contenido web estructurado en HTML, analizarlo y extraer los datos relevantes para diversos fines, como la recopilación de información para análisis, minería de datos o la construcción de bases de datos. Esta técnica es especialmente útil cuando las APIs disponibles no brindan toda la información necesaria o cuando la web no ofrece una forma sencilla de acceder a los datos.

A lo largo de este artículo, exploraremos cómo realizar scraping de datos con Beautiful Soup, los pasos esenciales para configurarlo en tu entorno de desarrollo y las mejores prácticas para asegurarte de que tu proceso sea eficiente, legal y ético. Si eres nuevo en este campo, este artículo te servirá como guía completa para comenzar a utilizar Beautiful Soup con Python, uno de los métodos más efectivos para extraer datos de la web.

El uso de Beautiful Soup para el scraping de datos con Python se ha convertido en una habilidad fundamental en el mundo de la programación y el análisis de datos. Esto se debe a su facilidad de uso, flexibilidad y amplia compatibilidad con diferentes tipos de contenido web. Al trabajar con esta herramienta, es posible realizar tareas como la obtención de titulares de noticias, precios de productos, información de contacto o cualquier tipo de datos que se encuentren estructurados en HTML o XML.

Aunque el scraping de datos con Beautiful Soup es una herramienta poderosa, también requiere un manejo responsable. Es importante tener en cuenta las leyes de privacidad y los términos de uso de los sitios web de los cuales se obtiene la información. En algunos casos, las páginas web pueden restringir el acceso a sus datos o imponer límites en la cantidad de solicitudes que se pueden hacer para evitar sobrecargar sus servidores. Por lo tanto, es fundamental realizar scraping de forma ética y respetuosa.

¿Qué es el Scraping de Datos Web?

El scraping de datos con Beautiful Soup es el proceso de extraer información de páginas web utilizando código para navegar y analizar los datos estructurados en HTML o XML. Esta técnica permite a los usuarios obtener grandes volúmenes de datos de diversas páginas web sin necesidad de intervención manual. Python, junto con bibliotecas como Beautiful Soup, se ha convertido en una herramienta popular para realizar este tipo de tareas.

El proceso básico de scraping de datos con Beautiful Soup generalmente consta de tres pasos: primero, se obtiene el contenido de la página web que se desea analizar; segundo, se procesa ese contenido para extraer los datos relevantes; y finalmente, se organiza y almacena la información de manera que sea fácil de usar. Beautiful Soup facilita este proceso al proporcionar una forma intuitiva de navegar por el árbol HTML y buscar elementos específicos, como etiquetas, atributos o clases, lo que permite extraer la información necesaria de manera eficiente.

Una de las ventajas de scraping de datos con Beautiful Soup es su capacidad para manejar páginas web que no están optimizadas para ofrecer datos fácilmente accesibles a través de APIs. Algunas páginas web solo presentan la información en su interfaz de usuario, lo que puede dificultar el acceso a los datos sin realizar un análisis más profundo del código fuente de la página. Beautiful Soup resuelve este problema al proporcionar herramientas para extraer datos directamente desde el HTML, lo que permite acceder a la información de manera mucho más sencilla.

Además, el uso de Python como lenguaje de programación para el scraping de datos con Beautiful Soup es una excelente opción debido a su gran ecosistema de bibliotecas y herramientas que facilitan la extracción y manipulación de datos. Python permite integrar Beautiful Soup con otras bibliotecas como Requests para obtener contenido web, Pandas para procesar y analizar los datos extraídos, y Selenium para interactuar con páginas web dinámicas que requieren JavaScript para cargar su contenido.

Instalación de Beautiful Soup y Requisitos Previos

Para comenzar con el scraping de datos con Beautiful Soup, lo primero que necesitas es configurar tu entorno de desarrollo. Afortunadamente, la instalación de Beautiful Soup es un proceso sencillo. Solo necesitas tener Python instalado en tu sistema y luego utilizar el gestor de paquetes pip para instalar las bibliotecas necesarias.

Instalación de las Bibliotecas Requeridas

Para instalar Beautiful Soup y sus dependencias, abre tu terminal y ejecuta los siguientes comandos:

pip install beautifulsoup4

pip install requests

La biblioteca requests es útil para realizar solicitudes HTTP y obtener el contenido HTML de las páginas web, mientras que beautifulsoup4 es la biblioteca principal que facilita la manipulación del HTML para extraer los datos.

Requisitos Adicionales

Es posible que también necesites instalar un parser HTML, como lxml o html5lib, ya que Beautiful Soup depende de ellos para analizar correctamente el contenido de las páginas web. Para instalar lxml, por ejemplo, puedes usar el siguiente comando:

pip install lxml

Con estas herramientas ya instaladas, estás listo para comenzar a hacer scraping de datos con Beautiful Soup.

Realizando el Scraping de Datos con Beautiful Soup

Ahora que tienes el entorno listo, es hora de comenzar a hacer scraping de datos con Beautiful Soup. El primer paso es obtener el contenido HTML de la página web que deseas analizar. Para ello, puedes utilizar la biblioteca requests para realizar una solicitud HTTP y obtener la respuesta con el contenido de la página.

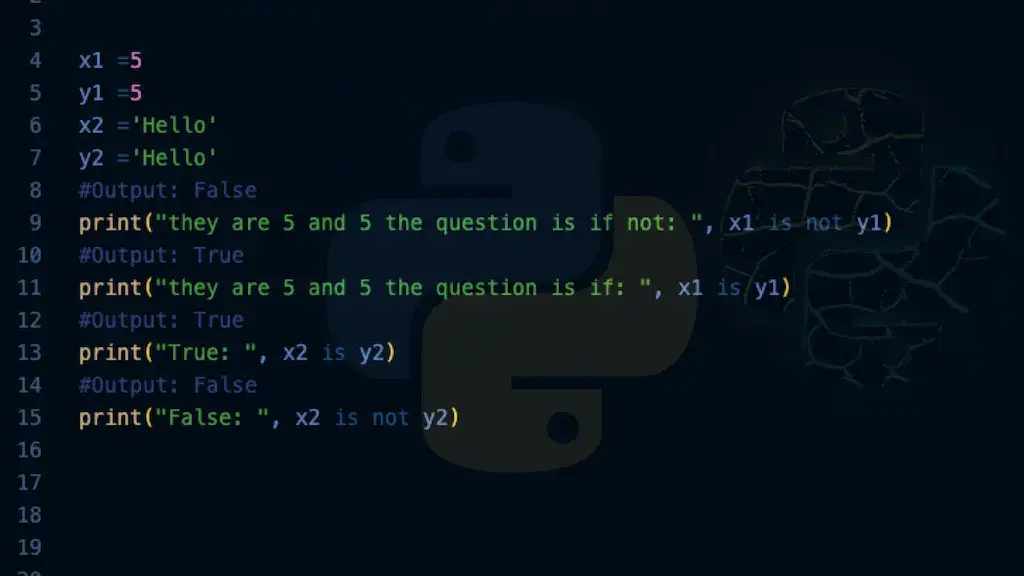

Ejemplo de Código para Realizar Scraping

Aquí tienes un ejemplo básico de cómo hacer scraping de datos con Beautiful Soup para obtener los títulos de los artículos en una página web de noticias:

import requests

from bs4 import BeautifulSoup

# URL de la página que deseas analizar

url = 'https://www.example.com/noticias'

# Realizamos la solicitud HTTP para obtener el contenido de la página

response = requests.get(url)

# Verificamos que la solicitud fue exitosa

if response.status_code == 200:

# Creamos el objeto BeautifulSoup para analizar el contenido HTML

soup = BeautifulSoup(response.content, 'html.parser')

# Encontramos todos los elementos de la página que contienen los títulos de los artículos

titles = soup.find_all('h2', class_='article-title')

# Imprimimos los títulos de los artículos

for title in titles:

print(title.get_text())

else:

print("Error al acceder a la página")

Este código realiza una solicitud HTTP a la página web, obtiene el contenido y utiliza Beautiful Soup para analizarlo y extraer los títulos de los artículos. El método find_all() permite buscar todos los elementos que coincidan con la etiqueta <h2> y la clase article-title, y luego se imprime el texto de cada título.

Buenas Prácticas en el Scraping de Datos

Aunque el scraping de datos con Beautiful Soup es una herramienta poderosa, es importante seguir ciertas buenas prácticas para garantizar que el proceso sea eficiente, ético y legal.

No Sobrecargar los Servidores

Una de las principales preocupaciones al hacer scraping de datos es evitar sobrecargar los servidores de las páginas web. Para ello, es recomendable agregar pausas entre las solicitudes o realizar solicitudes de manera controlada. Puedes usar la función time.sleep() en Python para insertar un retraso entre cada solicitud y así no enviar demasiadas peticiones en un corto período de tiempo.

Respetar los Términos de Uso

Antes de hacer scraping de una página web, es crucial revisar los términos de uso del sitio. Algunos sitios web prohíben el scraping explícitamente en sus políticas. Asegúrate de obtener los permisos necesarios o de utilizar los datos solo para fines legítimos y dentro de los límites establecidos por el propietario del sitio.

Uso de APIs cuando Sea Posible

Si el sitio web ofrece una API oficial para acceder a los datos, es recomendable utilizarla en lugar de hacer scraping directamente desde el HTML. Las APIs son una forma más eficiente y legalmente segura de obtener los datos de la web. Algunas páginas web, como Twitter o GitHub, proporcionan APIs públicas que permiten acceder a la información de manera estructurada.

En este enlace puedes encontrar una lista de APIs públicas disponibles para diferentes tipos de servicios web.